什么是大模型¶

约 1149 个字 14 张图片 预计阅读时间 6 分钟

- 具有超大规模参数的与训练语言模型

- 主要为 Transformer 解码器架构

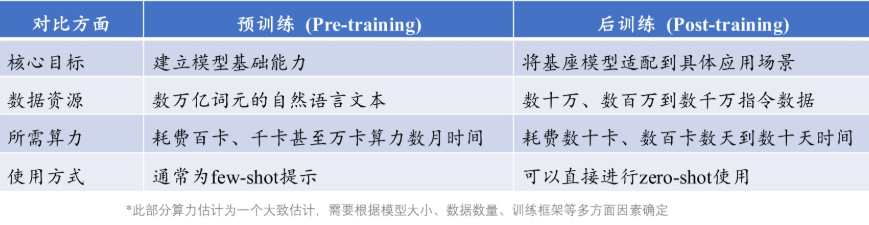

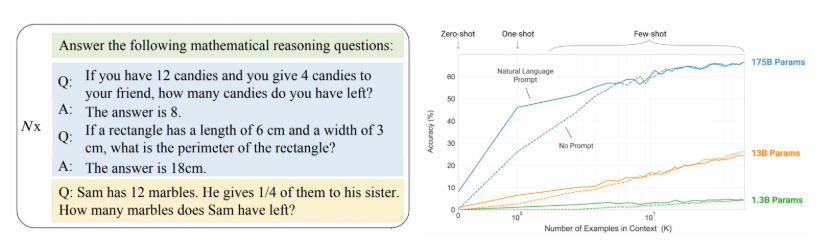

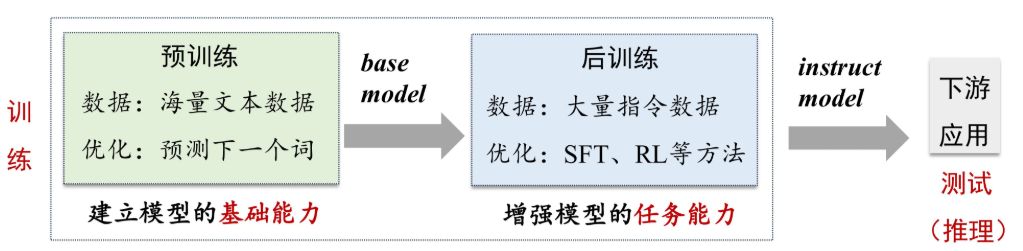

- 训练分为与训练和后训练,通过与训练建立模型的基础能力(利用海量的文本数据),再用大量的指令数据通过 SFT(监督微调,有标签数据进行针对性调整)和 RL(强化学习)等方式来后训练。最后投入下游运用。

- 预训练需要的算力更大。

大语言模型构建概览¶

- 预训练:

- 后训练:

-

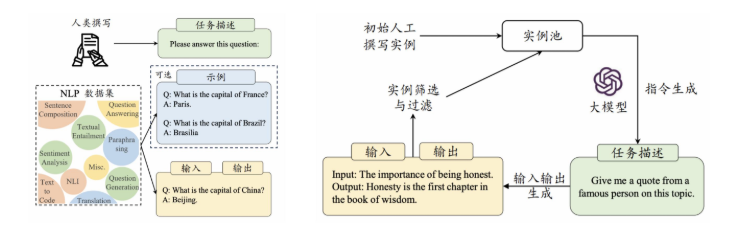

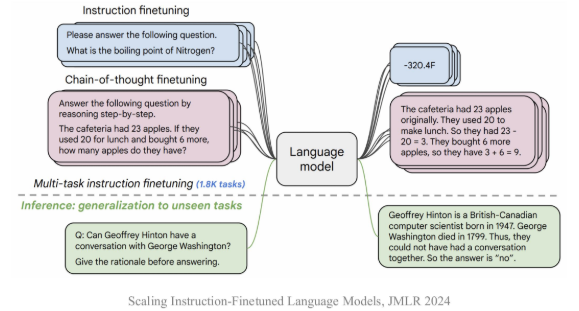

指令微调 (Instruction Tuning)

-

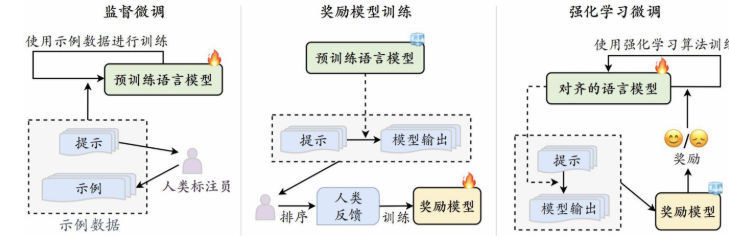

人类对齐(HumanAlignment)

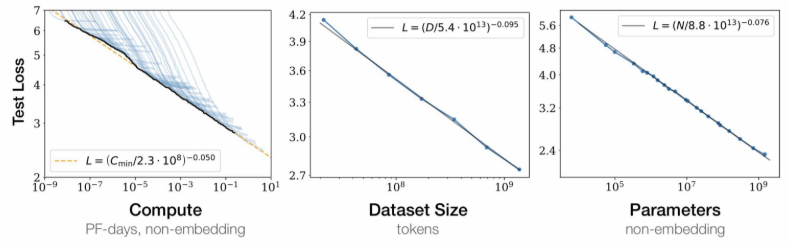

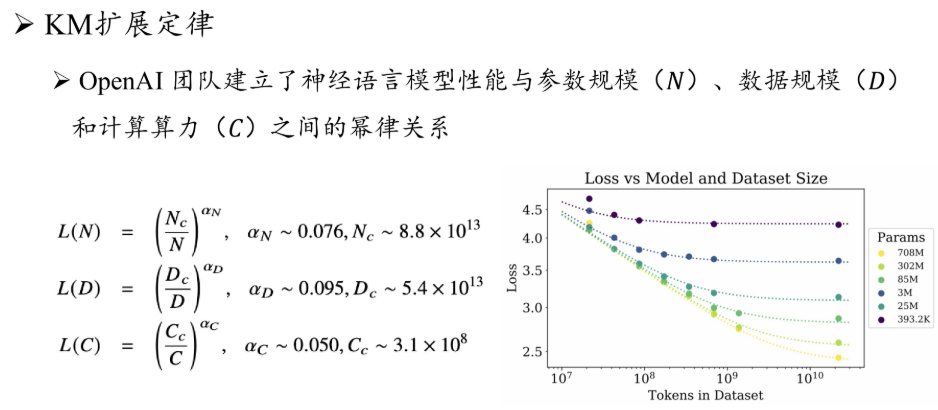

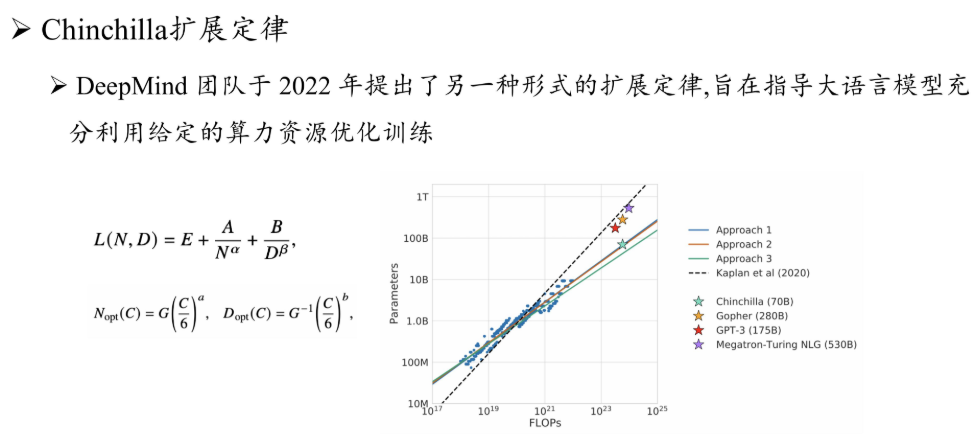

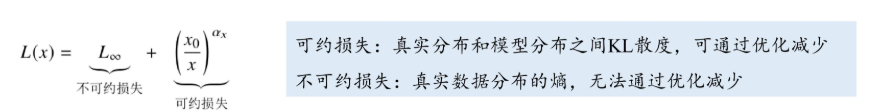

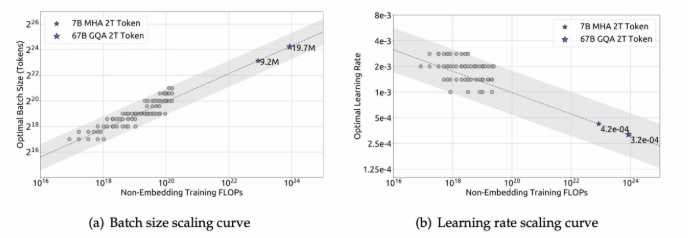

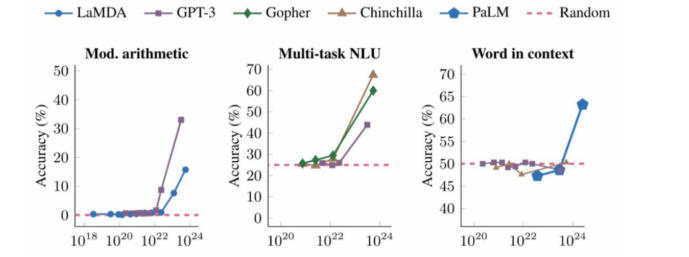

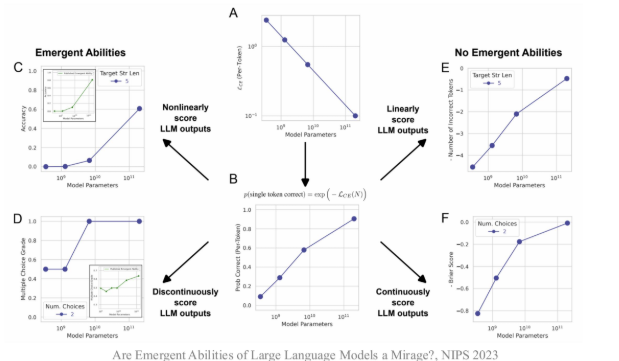

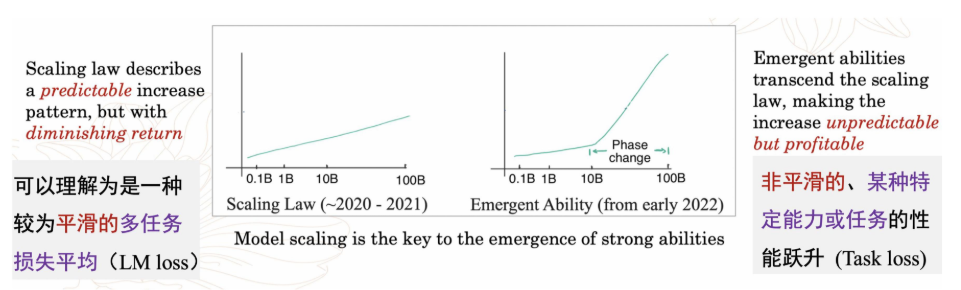

扩展定理¶

几种扩展定理 :¶

对扩展定理的思考¶

涌现能力¶

总结:¶

- 大模型核心技术

- 规模扩展:扩展定律奠定了早期大模型的技术路线,产生了巨大的性能提升

- 数据工程:数据数量、数据质量以及配制方法极其关键

- 高效预训练:需要建立可预测、可扩展的大规模训练架构

- 能力激发:预训练后可以通过微调、对齐、提示工程等技术进行能力激活

- 人类对齐:需要设计对齐技术减少模型使用风险,并进一步提升模型性能

- 工具使用:使用外部工具加强模型的弱点,拓展其能力范围

学习心得¶

现有大模型的技术在很多方向已经趋于成熟,但是深度学习尤其是神经网络导致的不可解释性导致很多技术的推进只能是尝试和经验总结,总结当前的技术特点,针对不足的地方用额外的方法弥补。比如希望大模型能够像人一样思考,就是用 RL 等技术后训练,针对长上下文的限制,用 RAG 来增强检索,总体上感觉目前的 LLM 还处于一个不停打补丁修正的环节,这可能还是因为 Transformer 这个结构的底层原因,也许未来的日子里我们能够找到更终极更底层的架构实现,让大模型达到超越人类思考的形式,而不是现在一样知识模仿人类的思考。