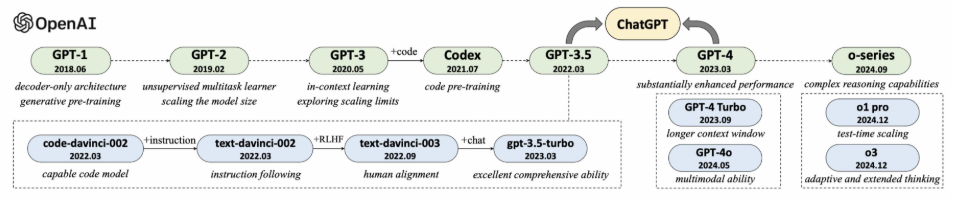

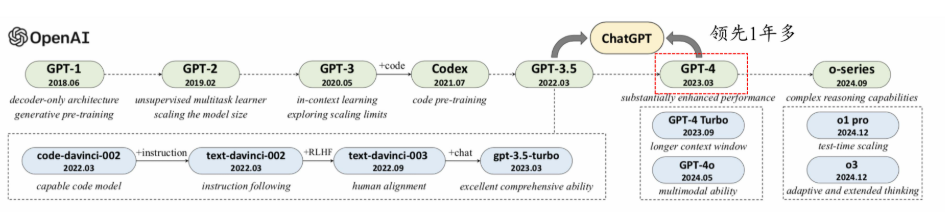

GPT 模型的发展历程¶

约 1146 个字 17 张图片 预计阅读时间 6 分钟

GPT系列模型成体系推进¶

- 2017年,谷歌提出Transformer

- 2018年,OpenAI提出GPT(1亿+参数)

- 2019年,GPT-2(15亿参数)

- 2020年,GPT-3(1750亿参数)

- 2021年,CodeX(基于GPT-3,代码预训练)

- 2021年,WebGPT(搜索能力)

- 2022年2月,InstructGPT(人类对齐)

- 2022年11月,ChatGPT(对话能力)

- 2023年3月,GPT-4(推理能力、多模态能力)

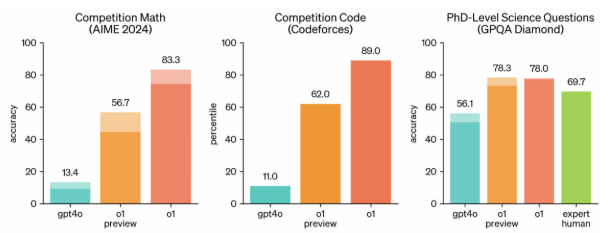

- 2024年9月,o1(深度思考能力提升)

- 2025年1月,o3(深度思考能力进一步增强)

可以说 GPT 的发展对现在的大模型发展起到了深远影响

GPT系列模型发展历程¶

GPT 系列模型的技术演变¶

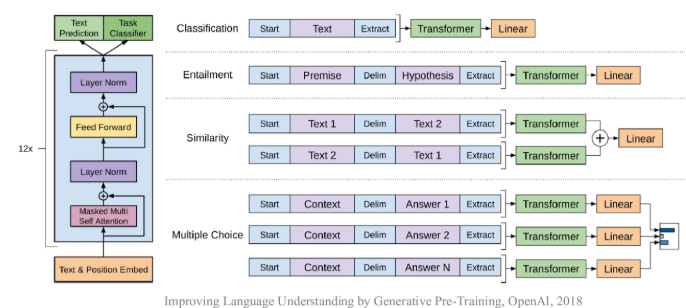

GPT-1 (1.1亿参数)¶

GPT-2(15亿参数)¶

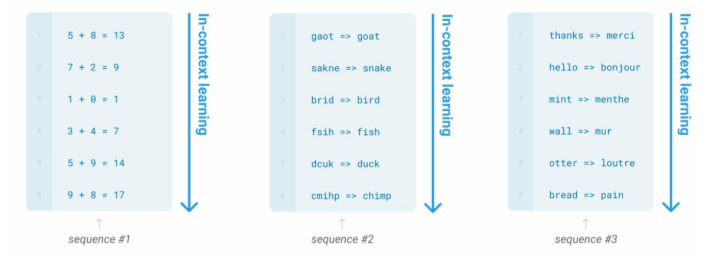

GPT-3¶

CodeX¶

WebGPT¶

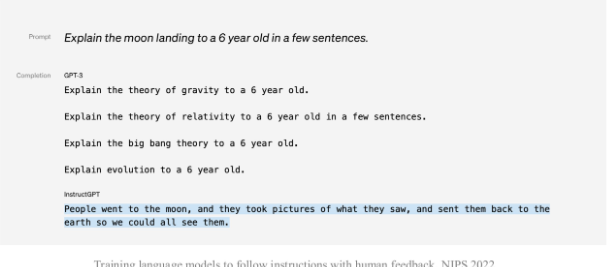

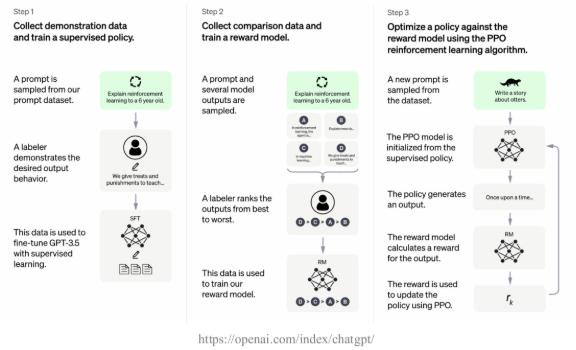

InstructGPT¶

ChatGPT¶

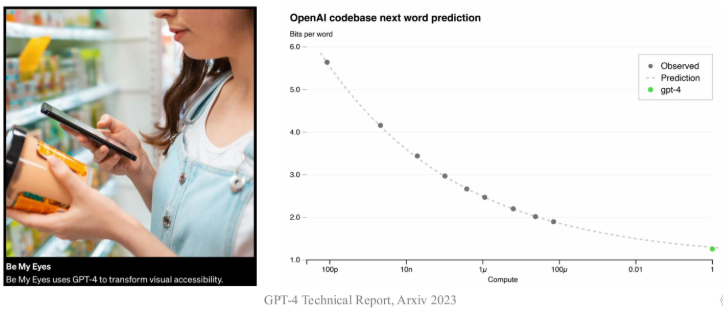

GPT4¶

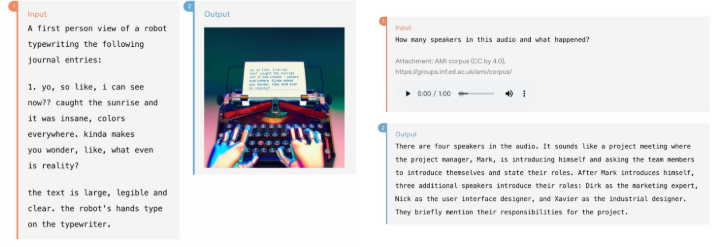

GPT-40¶

o系列模型¶

0-series¶

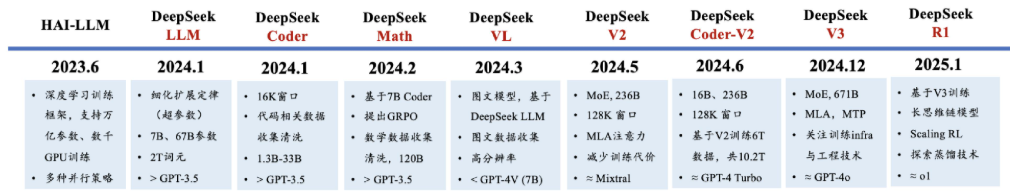

DeepSeek 系列模型的技术演变¶

- DeepSeek系列模型发展历程

- 训练框架:HAI-LLM

- 语言大模型:DeepSeekLLM/V2/V3、Coder/Coder-V2、Math

- 多模态大模型:DeepSeek-VL

- 推理大模型:DeepSeek-R1

- DeepSeek实现了较好的训练框架与数据准备

- 训练框架HAI-LLM(发布于2023年6月)

- 大规模深度学习训练框架,支持多种并行策略

- 三代主力模型均基于该框架训练完成

- 训练框架HAI-LLM(发布于2023年6月)

- 数据采集

- V1和Math的报告表明清洗了大规模的Common Crawl,具备超大规模数据处理能力

- Coder的技术报告表明收集了大量的代码数据

- Math的技术报告表明清洗收集了大量的数学数据

- VL的技术报告表明清洗收集了大量多模态、图片数据

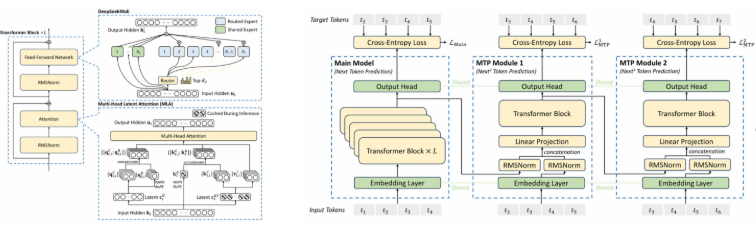

- DeepSeek进行了重要的网络架构、训练算法、性能优化探索

- V1探索了scalinglaw分析(考虑了数据质量影响),用于预估超参数性能

- V2提出了MLA高效注意力机制,提升推理性能

- V2、V3都针对MoE架构提出了相关稳定性训练策略

- V3使用了MTP(多token预测)训练

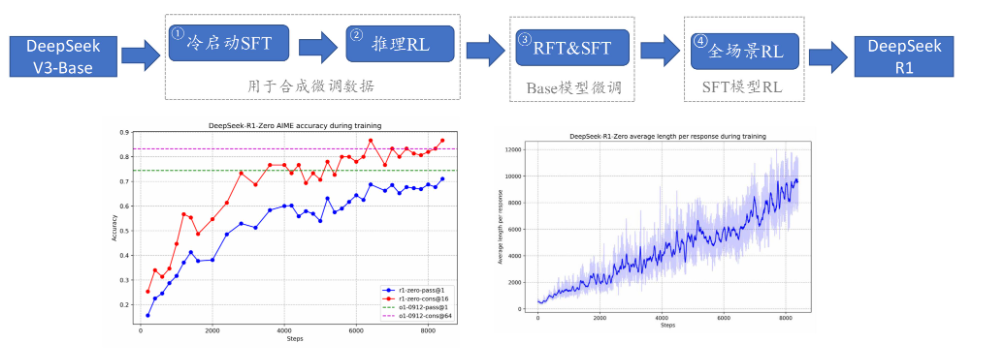

- Math提出了PPO的改进算法GRPO

- V3详细介绍Infrastructure的搭建方法,并提出了高效FP8训练方法

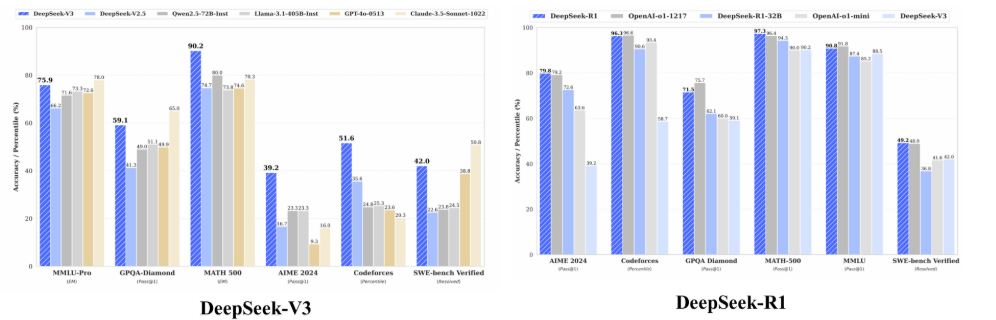

- DeepSeek-V3

- DeepSeek-R1

- DeepSeek-V3和DeepSeek-R1均达到了同期闭源模型的最好效果

DeepSeek 的意义¶

- 为什么DeepSeek会引起世界关注

心得体会¶

GPT 的发展看起来是一个很漫长的过程,但是实际上也就几年的时间,Transformer 模型一开始仅仅是用于机器翻译上,谁也不会预料到他给我们的时代带来如此巨大转机。与此同时,中国的 LLM 发展也丝毫不落于美国,这也更加激励我们要把握时代风口,全民 ai 的时代很快就要到来了。与此同时,对于模型迭代的认知也是我们需要好好学习的经验。